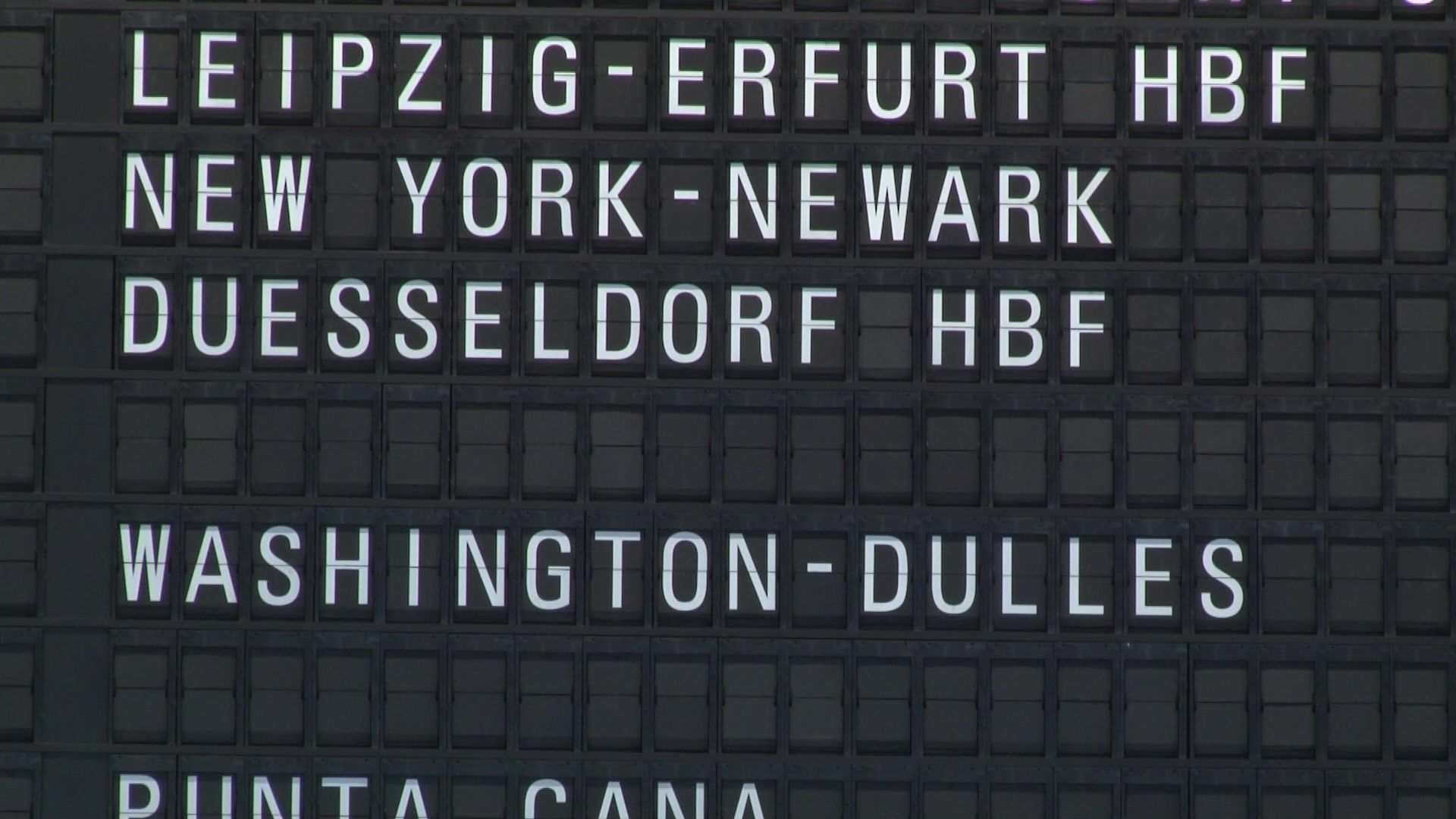

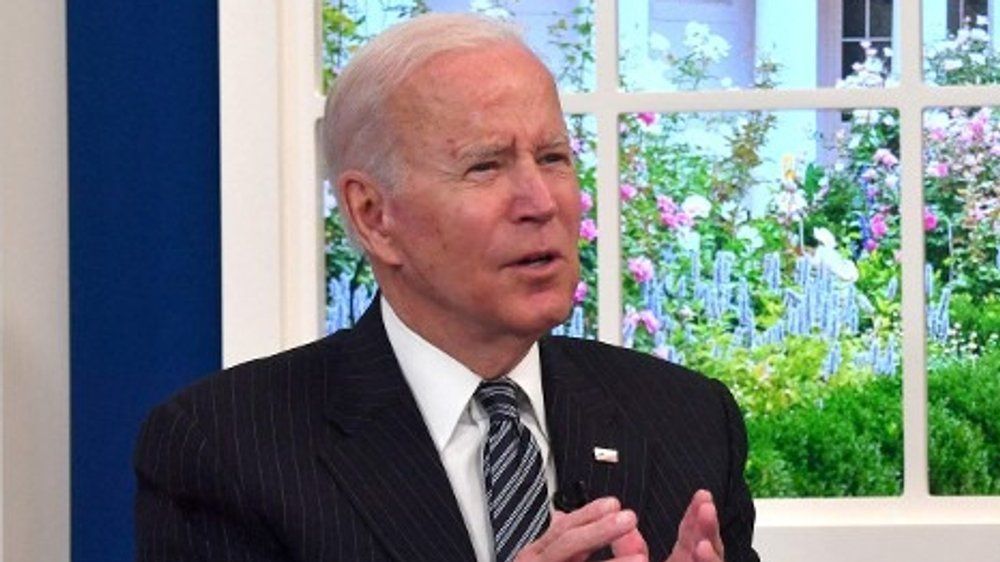

Biden erklärt Corona-Pandemie in den USA für beendet

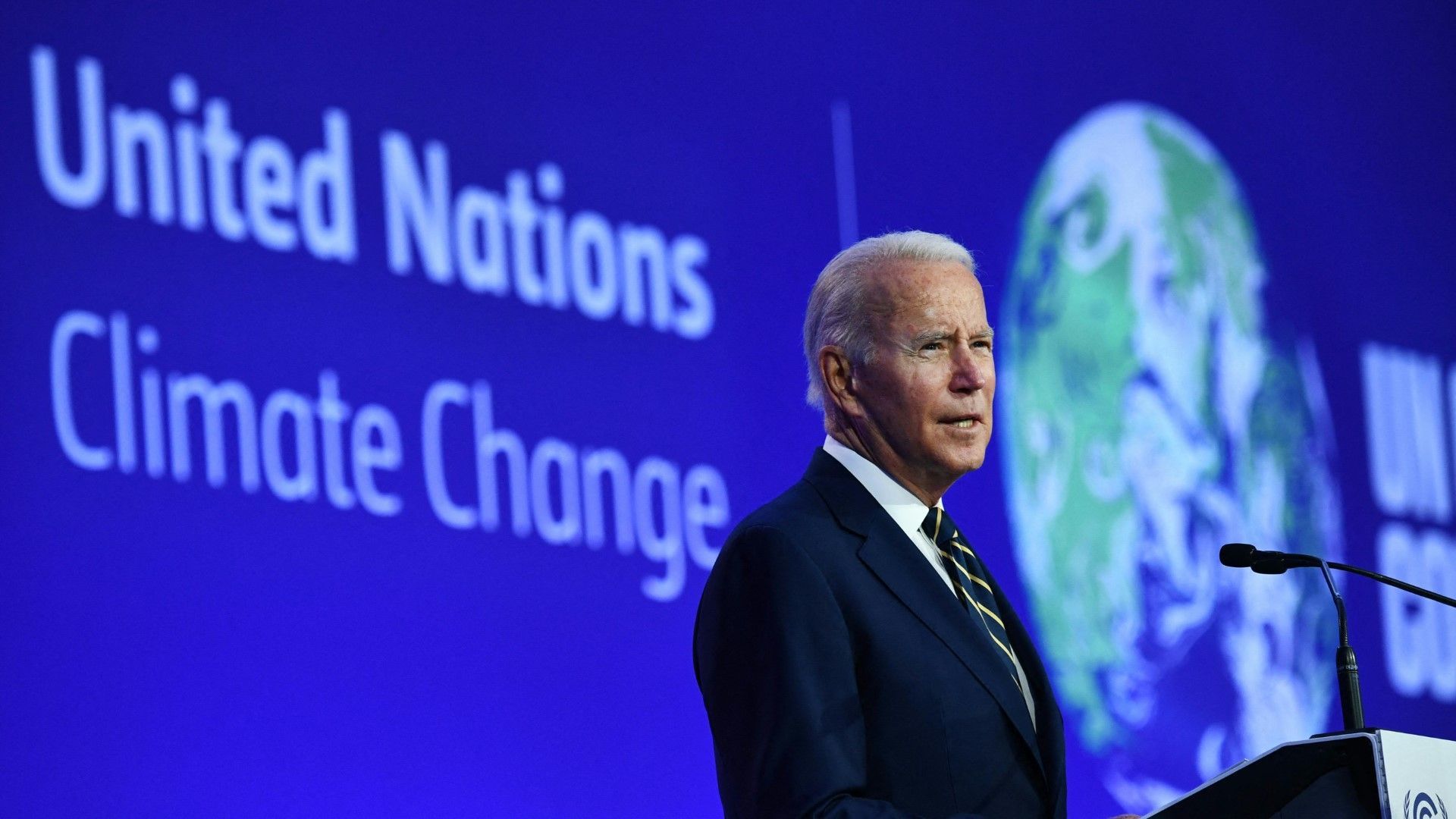

Während Deutschland Maßnahmen für den kommenden Winter trifft, machen die USA sich frei von Corona-Sorgen. In einem kürzlichen Interview erklärte Präsident Joe Biden die Pandemie in den Vereinigten Staaten für beendet.